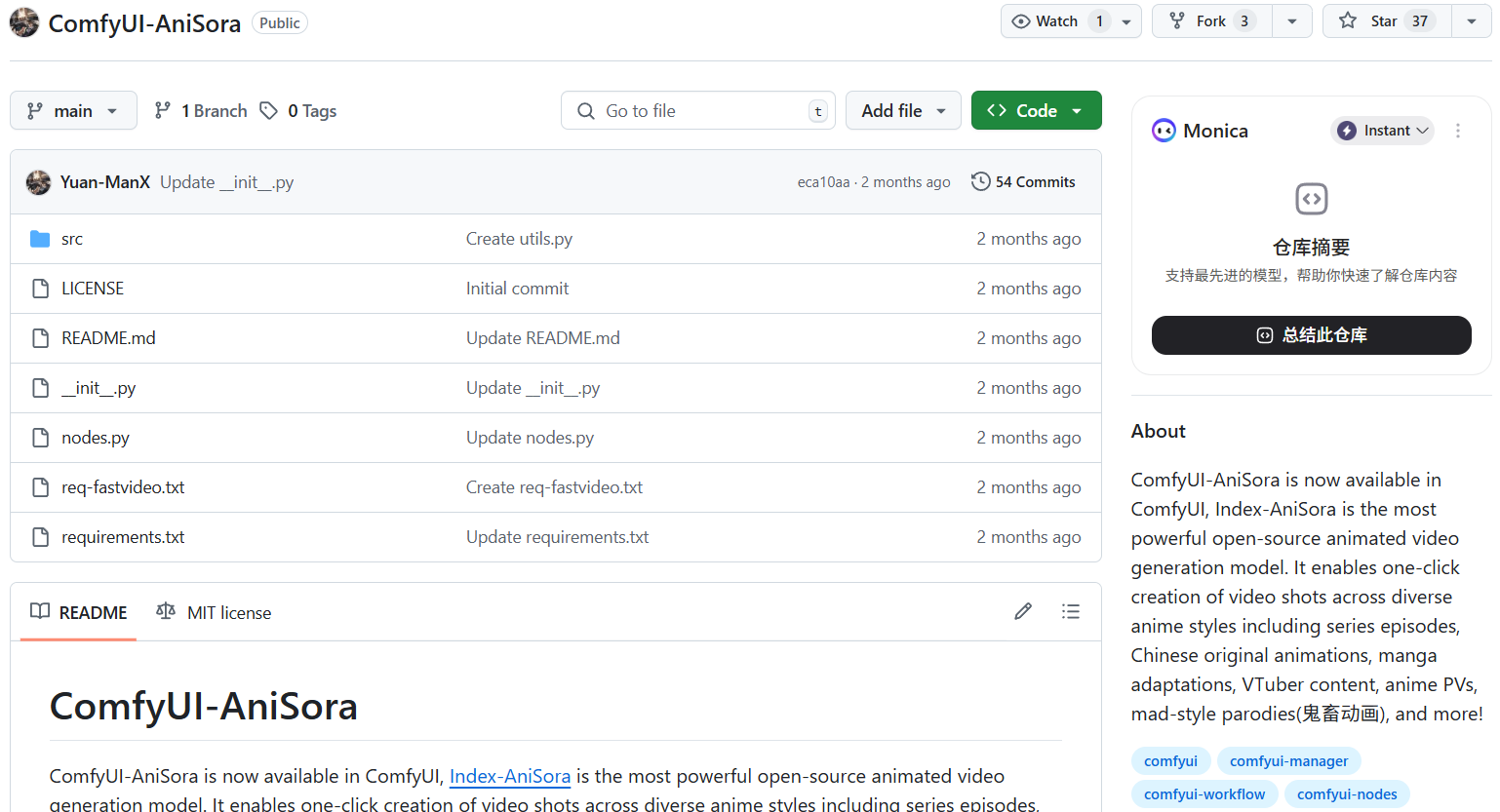

ComfyUI-AniSora

综合介绍

ComfyUI-AniSora是一个开源的自定义节点,它将强大的动漫视频生成模型AniSora集成到了模块化的AI工具ComfyUI中。这个项目由哔哩哔哩(Bilibili)的Index-AniSora项目推动,该项目旨在为动漫创作领域提供最先进的开源视频生成技术。 ComfyUI-AniSora的核心是利用先进的图像到视频(Image-to-Video)和文本到视频(Text-to-Video)模型,让用户能够通过简单的节点式操作,将静态图片或文字描述转换成具有连贯动态和稳定角色形象的动漫视频片段。该工具基于强大的Wan2.1-14B基础模型,能够生成480p分辨率的视频,并且在消费级显卡(如RTX 4090)上也能高效运行。 用户通过这个节点,可以轻松创作各种风格的动画,包括动画剧集、国产动画、漫画改编、虚拟主播(VTuber)内容以及动画宣传片(PV)等。

功能列表

- 集成先进模型:在ComfyUI中直接使用由哔哩哔哩(Bilibili)开源的Index-AniSora V2模型,该模型基于

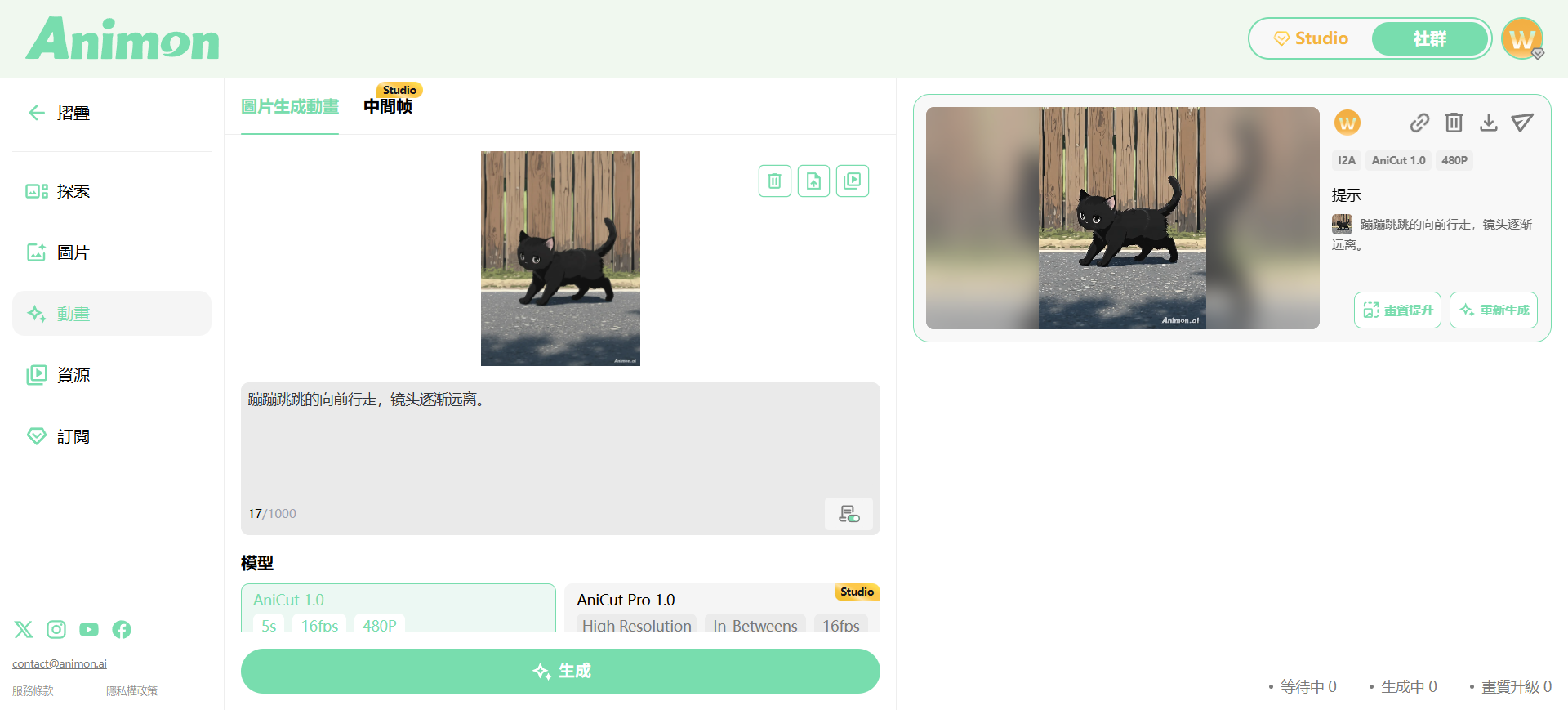

Wan2.1-I2V-14B-480P,专门用于生成高质量动漫视频。 - 图像到视频(Image-to-Video):支持将单张或多张图片作为输入,生成动态视频。用户可以提供起始帧、结束帧,甚至中间帧来精确控制视频的动作流程和场景变化。

- 文本到视频(Text-to-Video):通过输入详细的文本提示词(Prompt),直接生成符合描述的视频内容。

- 高角色一致性:AniSora模型经过专门优化,能够有效解决AI视频生成中常见的角色形象闪烁或变化的问题,在视频中保持较高的角色一致性。

- 多种动漫风格:能够生成多种主流的动漫风格,包括日本动画、中国风动画(国创)、漫画改编风格等。

- 支持LoRA模型:兼容社区开发的LoRA模型(如

lightx2v),可在工作流中加载以优化输出效果,例如用更少的采样步骤生成更平滑的视频。 - 模块化工作流:作为ComfyUI的一个节点,它可以无缝地与其他上百种自定义节点结合,构建出复杂且高度可定制的视频生成、处理与后期工作流。

使用帮助

ComfyUI-AniSora作为一个自定义节点包,其使用前提是用户已经安装并熟悉ComfyUI的基本操作。以下是详细的安装和使用流程。

第一步:安装ComfyUI-AniSora节点

- 启动终端或命令行工具:根据你的操作系统(Windows, macOS, Linux),打开一个命令行窗口。

- 定位到

custom_nodes目录:使用cd命令进入你的ComfyUI安装路径下的custom_nodes文件夹。路径通常如下:cd /path/to/your/ComfyUI/custom_nodes - 克隆代码仓库:执行以下git命令,将ComfyUI-AniSora的源代码从GitHub克隆到本地。

git clone https://github.com/Yuan-ManX/ComfyUI-AniSora.git - 安装依赖库:进入刚刚克隆的文件夹,并安装其所需的Python依赖库。这个节点有两个需求文件。

cd ComfyUI-AniSora pip install -r req-fastvideo.txt pip install -r requirements.txt pip install -e .注意:建议在为ComfyUI配置的Python虚拟环境中执行这些命令,以避免与系统或其他项目的库产生冲突。

第二步:下载核心模型文件

AniSora的运行依赖于多个大型模型文件,需要手动下载并放置到ComfyUI的指定文件夹中。

- 安装Git LFS:主模型文件很大,存放于Hugging Face,需要使用Git Large File Storage (LFS)来下载。如果尚未安装,请先安装它。

git lfs install - 下载AniSora V2主模型:这是最核心的扩散模型。

- 模型:

Wan2.1-I2V-14B-480P - 下载地址:https://huggingface.co/Wan-AI/Wan2.1-I2V-14B-480P

- 放置路径:将下载的

.safetensors文件放入ComfyUI安装目录下的ComfyUI/models/diffusers/文件夹。

- 模型:

- 下载其他必需模型:除了主模型,工作流还需要文本编码器、VAE等模型。

- 文本编码器 (Text Encoder):

- 模型:

umt5_xxl_fp16.safetensors - 下载地址:https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/blob/main/split_files/text_encoders/umt5_xxl_fp16.safetensors

- 放置路径:

ComfyUI/models/text_encoders/

- 模型:

- 视觉辅助编码器 (Clip Vision):

- 模型:

clip_vision_g.safetensors(通常SD3或Flux工作流已有) - 放置路径:

ComfyUI/models/clip_vision/

- 模型:

- VAE (变分自动编码器):

- 模型:

vae.safetensors - 下载地址:https://huggingface.co/Wan-AI/Wan-VAE/tree/main

- 放置路径:

ComfyUI/models/vae/

- 模型:

- 文本编码器 (Text Encoder):

- (可选) 下载优化LoRA模型:为了提升生成速度和效果,可以下载

lightx2vLoRA。- 模型:

Wan21_T2V_14B_lightx2v_cfg_step_distill_lora_rank32.safetensors - 下载地址:https://huggingface.co/Kijai/WanVideo_comfy/blob/main/Wan21_T2V_14B_lightx2v_cfg_step_distill_lora_rank32.safetensors

- 放置路径:

ComfyUI/models/loras/

- 模型:

第三步:构建并运行工作流

安装完成后,重启ComfyUI。现在你可以在节点菜单中找到AniSora相关的节点。

一个基础的 图像到视频 (Image-to-Video) 工作流通常包含以下节点和连接:

Load Image(加载图像):加载一张或多张图片作为视频的关键帧。如果只用一张,它将作为视频的起始画面。AniSora V2 Loader:这是核心加载器节点。它会自动配置并加载主模型、VAE和编码器等。你需要在此节点中指定之前下载的Wan2.1-I2V-14B-480P模型目录。Prompt Text(提示词):添加两个文本框,一个用于正面提示词,一个用于负面提示词。详细描述你希望视频动起来的场景、动作和风格。例如:“一个女孩正在转头,头发随风飘动,背景是蓝天白云”。KSampler(采样器):这是执行生成的核心节点。- 将

AniSora V2 Loader的MODEL、LATENT等输出连接到KSampler的对应输入。 - 关键参数设置:根据社区经验,使用

lightx2vLoRA时,可以采用非常激进的设置以获得快速且高质量的输出。steps(步数):4或6cfg(提示词引导系数):1.0sampler_name(采样器):lcmscheduler(调度器):simple

- 将

Save Animated WEBP / PNG(保存动画):将KSampler输出的IMAGE连接到此节点,用于将生成的一系列图像帧保存为动画文件。

如果你使用了lightx2v LoRA,则需要在AniSora V2 Loader和KSampler之间插入一个Load LoRA节点。

应用场景

- 动画短片制作对于独立动画师或小型工作室,ComfyUI-AniSora提供了一个快速将故事板或关键帧转化为动态预览的工具。创作者可以先绘制几个关键画面,然后利用模型的插值和生成能力,生成中间的过渡动画,大大缩短了传统逐帧动画的制作周期。

- 动态漫画和视觉小说可以将漫画的格画或视觉小说的静态背景、人物立绘作为输入,生成带有微动态(如眨眼、头发飘动、场景光影变化)的画面,提升作品的沉浸感和表现力。

- VTuber和直播内容虚拟主播可以使用该工具为自己的直播生成定制化的片头动画、场景素材或动态背景。例如,输入一张角色图和“角色在樱花树下喝茶”的提示词,即可生成一段生动的场景视频。

- 广告与社交媒体内容企业或个人内容创作者可以快速生成抓人眼球的动漫风格广告或社交媒体短视频。它非常适合制作产品宣传PV、动态表情包或“鬼畜”风格的搞笑视频。

QA

- 这个工具对硬件有什么要求?虽然模型经过优化,但依然需要一张显存较大的NVIDIA显卡。根据社区分享,至少需要12GB以上显存的显卡才能比较流畅地运行,推荐使用RTX 3090 (24GB) 或 RTX 4090 (24GB) 以获得最佳体验。

- 生成视频的效果不理想,总是有奇怪的扭曲怎么办?这通常与提示词、采样器设置或输入图像有关。可以尝试以下方法优化:

- 简化提示词:确保提示词清晰、具体,避免模糊或矛盾的描述。

- 调整CFG:降低

cfg值(例如1.0到2.5之间)可以减少画面的扭曲和过度锐化。 - 增加/减少步数:虽然使用LCM采样器时步数很低,但如果画面不稳定,可以适当增加几步(如从4增加到8)看看效果。

- 使用负面提示词:加入

distorted, blurry, ugly, bad quality等常见的负面词可以帮助改善画面质量。

- 如何生成更长时长的视频?默认生成的视频时长较短。要生成更长的视频,可以在相关节点中增加

frame_num(帧数)的参数值。 但请注意,增加帧数会显著增加计算时间和显存消耗。更有效的方法是分段生成,然后使用视频剪辑软件拼接起来。 - ComfyUI-AniSora和直接使用AniSora模型有什么区别?Index-AniSora是底层的AI模型本身。 ComfyUI-AniSora则是一个“外壳”或“接口”,它将这个复杂的模型封装成ComfyUI里的一个易于使用的节点。 这使得用户无需编写代码,只需通过拖拽和连接节点,就能利用AniSora的强大功能,并能将它与其他AI绘画、视频处理工具链结合起来。